Appleの「コミュニケーションセーフティ」機能の未来: プライバシーを犠牲にせずに子供を守る

Appleは、児童性的虐待材料という深刻な問題に対処するため、デバイス上およびiCloudでの検出ツールを導入しました。しかし、これらのツールは2022年12月に中止され、さらなる議論を呼び起こしました。

児童の安全を推進する組織「Heat Initiative」は、Appleに対してCSAM検出の放棄に関するキャンペーンを開始すると伝えました。Appleはこの問題に対して詳細な回答を提供し、その内容はWiredによって報告されました。

Appleの回答は、消費者の安全とプライバシーを最優先とする姿勢を強調しています。特に、暗号化された情報へのアクセスを試みることは、Appleのプライバシーとセキュリティに対する基本的な考え方に反するとのことです。

Appleのユーザープライバシーおよび児童安全のディレクター、Erik Neuenschwander氏は、児童性的虐待材料は許容できないとし、Appleがこの問題にどのように取り組んでいるかを説明しました。また、iCloudのデータをスキャンすることのリスクについても触れています。

Heat Initiativeのリーダー、Sarah Gardner氏は、Appleがこのプログラムを中止した理由について質問しました。

彼女は、Appleの提案したソリューションが、ユーザープライバシーのリーダーとしてのAppleの位置を強化するだけでなく、iCloudからの児童性的虐待の画像や動画を削除することを約束していたと述べました。

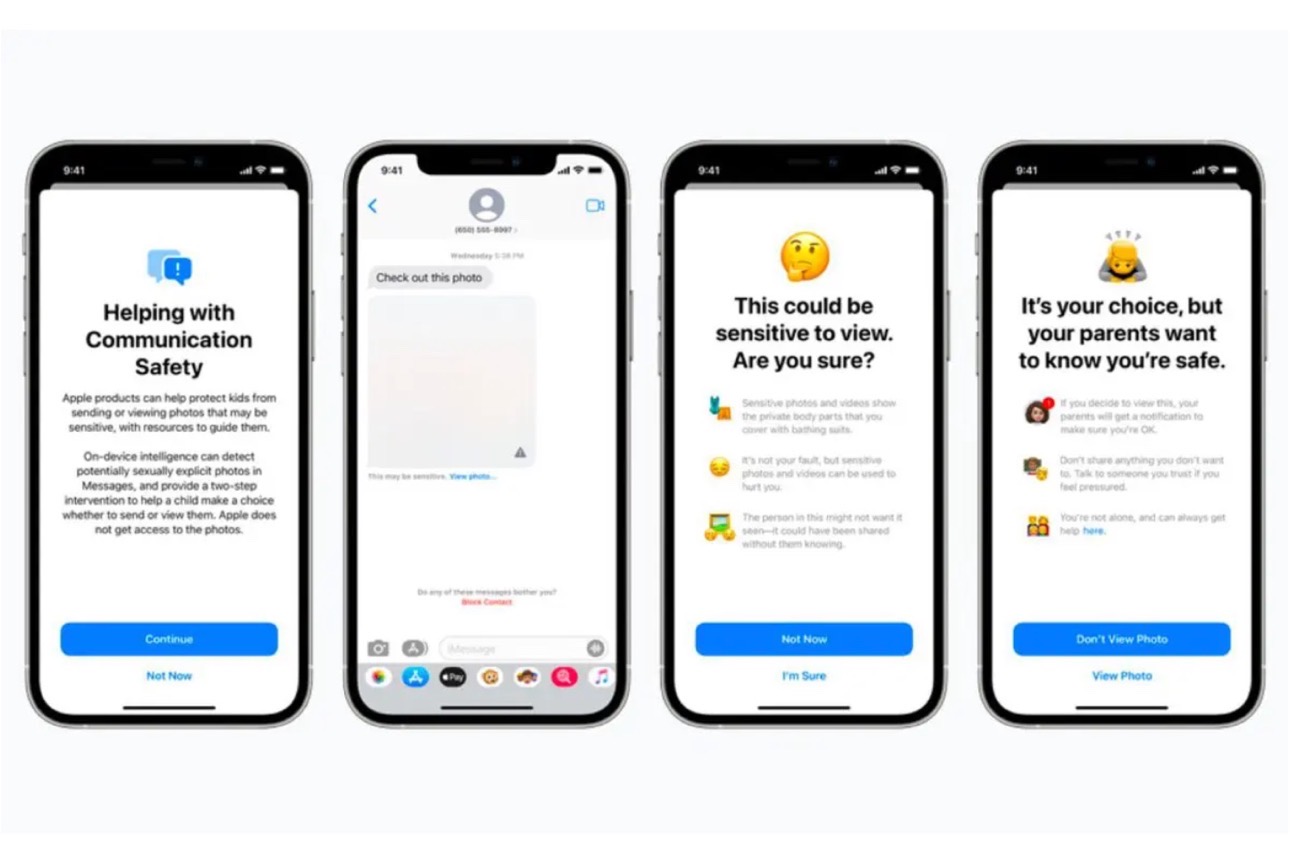

Appleは、ユーザーの信頼を損なうことなく、被害者を適切なリソースや警察に導くことを目指しています。また、Appleはユーザーの写真をスキャンしていないと明言しており、新しい「コミュニケーションセーフティ」機能を導入しています。

この機能は、iOS 17で大人向けにも提供される予定で、iMessageからの不要なヌード写真をフィルタリングすることができます。Appleは、今後もこのような機能をさらに拡充していく予定です。

(Via Apple Insider.)

LEAVE A REPLY