Appleの「iCloud」内の新しい児童保護機能に関する、賛否両論

Appleは児童ポルノの拡散に対する対策を発表しました、Appleは正しいことをしているのか?それとも行き過ぎているのか?賛否両論があります

児童ポルノを所持したり、渡したりすることは、正当に罰せられるべきことであり、それを作成している間に犯される重大な犯罪については語るまでもありません、刑法的な側面に加えて、まだ社会的排斥があります

Appleは正しい道を歩んでいる(Peter Müller)

Appleは、子どもや若者を性的虐待から守ることを3つの柱に据えている。何よりも、同社は高度な技術を駆使して、犯罪に関連した、あるいは単に攻撃的な素材のさらなる流通を阻止しています

このうち、2つの柱については、ほとんど議論の余地はないでしょう、と言うのも、どこに線を引くかを決めるのは、最終的には若いユーザーやその親だからです

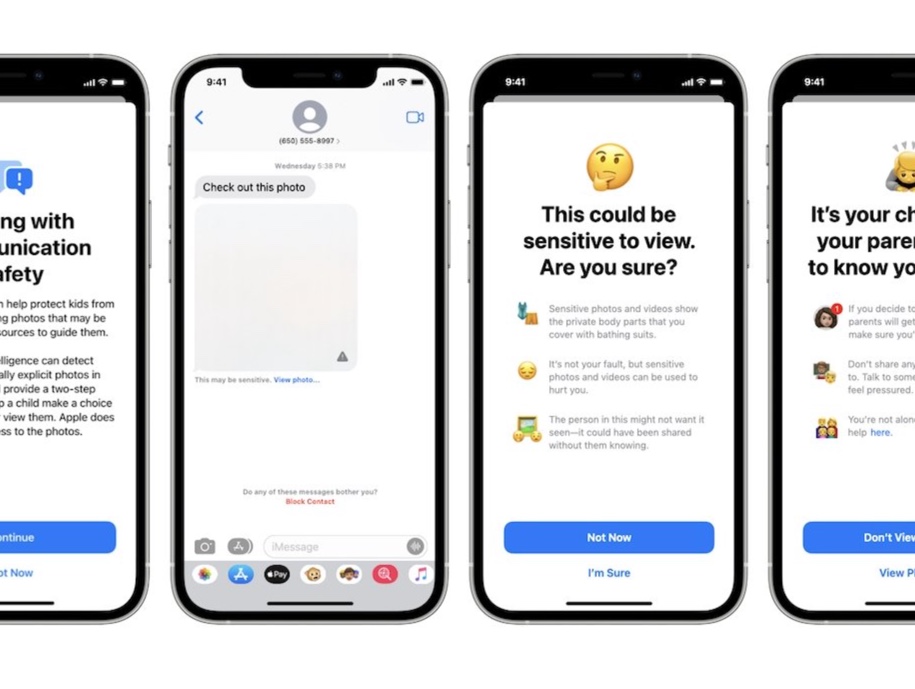

iOS 15、iPadOS 15、macOS 12 Montereyに搭載されているコミュニケーションアプリ「メッセージ」では、アルゴリズムによって性的に示唆に富む画像を認識して非表示にし、閲覧前にユーザーに警告を発します、画像の分析は、リモートサーバーではなく、デバイス自体で行われます

通信はエンド・ツー・エンドで暗号化され、会話に参加している人だけが画像を見ることができます、また、国境を越えた写真を自分で送ろうとすると、iPhoneが警告してくれます

残念ながら、多くの未成年者は、一見信頼できそうな人に簡単にセクスティングやヌードに誘われてしまいます、そして、一度デバイスから離れてしまったものは、コントロールすることができません

また、iPhone、iPad、MacのSiriやインターネット検索も、デバイス自体の機械学習アルゴリズムを使って、犯罪に関連する可能性のあるコンテンツを表示しないようにすべきです、前述のように、所持しているだけでも処罰の対象となります

3つ目の柱については、現在、意見が分かれています

AppleのアルゴリズムがiPhone上のすべての画像を分析して警報を鳴らし、児童ポルノがiCloudにダウンロードされます、これは気づかれないように起こるはずです

iPhoneは写真からハッシュ値を生成し、それを警察官のデータベースに集められた児童ポルノコンテンツと比較します、一致度がある閾値を超えた場合、AppleはiCloudに保存されている写真を復号化し、手動でチェックすることができます

刑法の場合、これでは検査官も面白くなく、アカウントがブロックされ、データは当局に渡されます、少なくともアメリカではそうなっています

ヨーロッパでは法的状況が異なると思われます、しかし、AppleはEU内のサーバーに保存されている画像の鍵も持っています、そうでなければ、自分のiCloudの画像をブラウザで見ることはできません

データ保護とプライバシーを最重要視するAppleは、1兆分の1の誤検出率を約束しています。iCloudに保存されているすべての写真を盗み見るのではなく、iPhoneのAIが疑わしいと報告したときだけ盗み見るのです

犯罪性が確認されたものだけがチェックされるので、休日のビーチではしゃぐ子どもたちの写真が原因で、アメリカ入国時に逮捕される心配はありません

しかし、そのような画像をiPhoneに残したり、インターネット上に保存したりしない方がいいです、正当な理由で無害だと思っていたものが、他人に悪用されたり、完全に誤解されたりする可能性があるからです

このように、犯罪的なコンテンツと合意の上でのエロティックなコミュニケーションとの区別をAppleが決めることには、不信感が残ります、このように、犯罪的なコンテンツと合意の上でのエロティックなコミュニケーションとの区別をAppleが決めることには、不信感が残ります

Appleは裁判官であるべきではない(Halyna Kubiv)

コロナ渦の2020年の児童虐待に関する事実と数字は憂慮すべきものです、ロックダウンのため、結果的に屋外での活動が少なくなり、児童ポルノが「ブーム」となり、それに関連する数字が増えています

警察の犯罪統計によると、2020年に報告された児童ポルノの件数は、2019年の12,262件から昨年の18,761件へと53%も増加しています

また、国際的にもその数は増加しています。International Watch Foundationによると、関連するWebサイトの数は昨年33%増加し、説得や脅迫によって自己生成された動画や画像もより大きな役割を果たしています

IMFは、2020年に約68,000件のこのようなケースを登録しました。2019年に報告された38,400件から77%増加しています

おそらくこれらの数字を考慮して、AppleはメッセージとiCloud Photosにおける今回の措置に動いたのでしょう、Appleの声明によると、同社のアクティブなiPhoneは約10億台、アクティブなAppleデバイスは16億5000万台弱

iPhoneに限定しても、世界人口の7分の1弱がiPhoneを使っていることになります、この7分の1の人々は、自分が撮影した写真が、既知の児童ポルノ事件のデータベースと比較される可能性があるということを考えながら生活しなければなりません

また、メーカーや協力団体が、このような対策の効果を示す数値を公表するかどうかは予見できません

データベースとのAppleのハッシュ比較はバックグラウンドで実行され、最初のレポートによると、データの分析に矛盾するオプションはおそらくありません

しばらくの間、Appleは、米国ではiOS 15、watchOS 8、macOS Montereyでのみそのような機能を有効にすると発表しました

そこでは、メーカーもNational Center for Missing and Exploited Children(NCMEC)と協力しています、しかし、理論的には、現在のすべてのデバイスや写真でスキャンを使用することができます

これは刑事訴追に関することなので、EUやドイツの裁判所などの現地機関も、EU市民に関しては何が合法なのかを判断しなければなりません

今回のAppleのNCMEC対策では、少なくとも米国の当局は、特に児童虐待に関連した犯罪者との戦いをすでに放棄しているという印象を受けます

データ交換に使用されているサーバーを探したり、データ交換の際に発生する金融取引にアクセスするのではなく、大量のスクリーニングに頼り、まず全員を容疑者にしてしまうのです

確かに、サイバー犯罪は量的にだけでなく質的にも発展していますが、法執行機関はそれにも対応しなければなりません

協力メーカーの膨大な写真データベースを、可能だからといって利用することは、法律で規制されている従来の捜査の代替や延長線上として機能すべきではありません

(Via Macwelt.)

LEAVE A REPLY