Appleによると、米国以外でCSAMの検出を拡大する場合は、国ごとに行う

AppleのiCloud Photosの児童性的虐待情報 (CSAM) コンテンツを検出する新機能は、まず米国でローンチします

Appleは、米国外への拡大は各国の法律と規制に基づいて国ごとに行われることを認めています

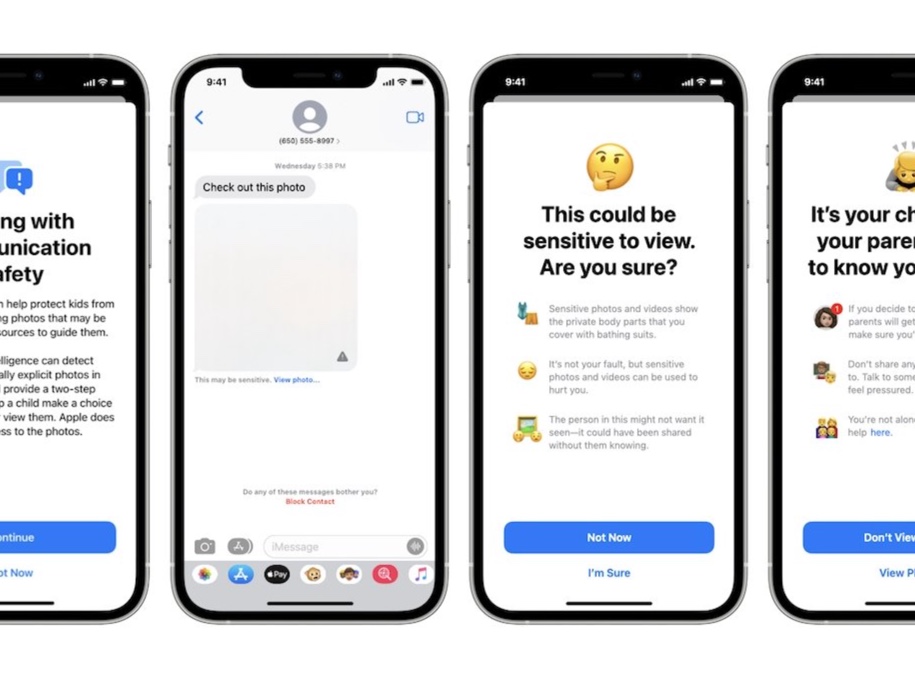

この新機能によってAppleは既知のCSAM画像がiCloud Photosに保存されていることを検出できるようになります、この機能は一部の情報源からかなりの反発を受けていますが、Appleはこれが子どもを保護するために必要であり、すべてはプライバシーを念頭に置いて行われると約束しています

最も一般的な懸念の1つは、他国の政府がこのシステムを他の目的に利用しようとした場合に何が起こるかということですが、この機能は米国でのみ提供される予定です、この懸念は、Edward Snowden氏や電子フロンティア財団(Electronic Frontier Foundation)など、さまざまな著名な情報筋から出ています

Appleは、米国外でのCSAM検出機能の拡張は、各国の法律や規制に基づいて国ごとに行われることを認めています、同社は、CSAMの検出を他の国に拡大する時期やその可能性について、具体的なスケジュールを明らかにしていません

Appleはこれまで、米国が同社の最大の市場であり、現地の法律や規制に最も精通している市場であることから、米国で最初に機能をローンチしてきました、今回の新しいCSAM検出システムもその例に漏れません

Appleの新しい子どもの安全に関するランディングページ

(Via 9to5Mac.)

LEAVE A REPLY