ChatGPTがChatbot Arenaのランキング首位!Google PaLM 2の評価結果が明かす興味深い事実

大規模モデルシステム組織(LMSYS Org)は、UCバークレイの学生と教員がUCサンディエゴとカーネギーメロン大学との協力で設立したオープンな研究組織です

その組織が主催するスケール言語モデル(LLM)のベンチマークである「Chatbot Arena」が一般向けに公開されています

Chatbot Arena

「Chatbot Arena」では、LLMをベースとした対話型AIの評価を行うオープンプラットフォームである「FastChat」に参加し、2つの匿名モデルとの対話を行い、どちらがより正確かを投票することができます

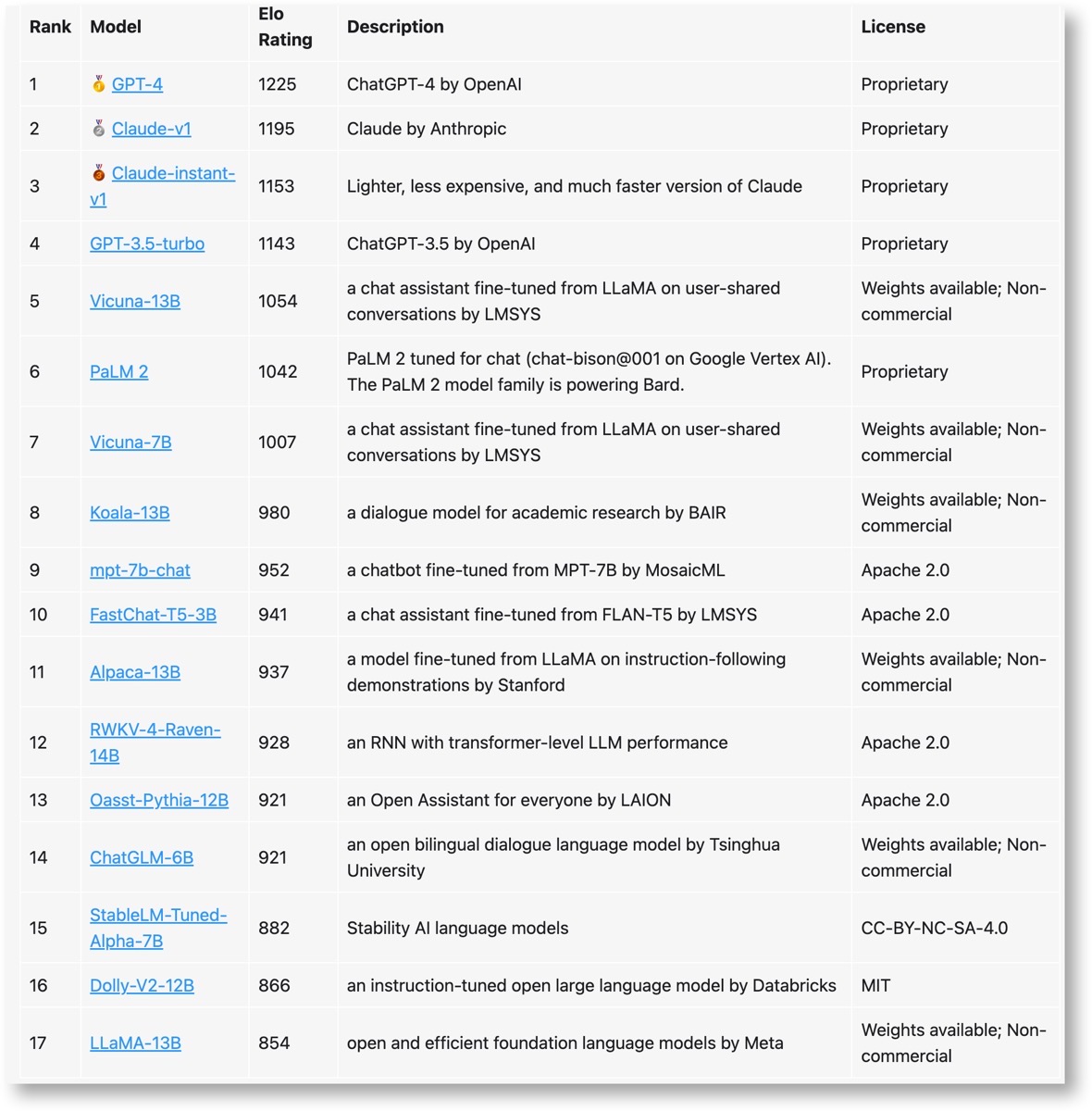

投票結果に基づいて、チェスなどで広く使用されるEloレーティングを用いた勝敗とレーティングの計算が行われ、順位が公表されます

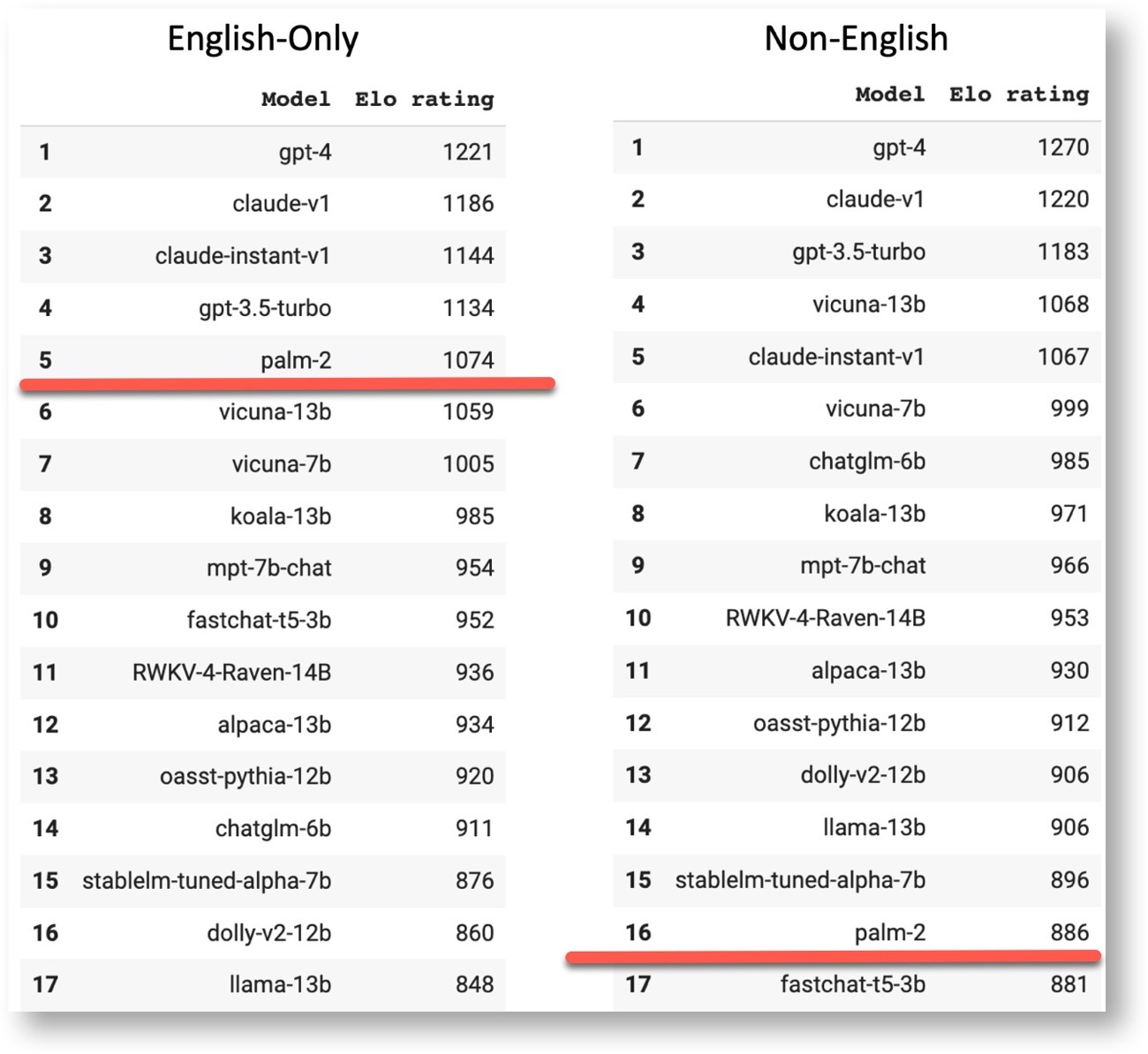

- 2023年4月24日から5月22日までの27,000件の匿名投票データに基づくランキング

OpenAIのGPT-4に基づくChatGPTが1位になり、OpenAIの競合であるAnthropicのClaude-v1とその軽量モデルが2位と3位になりました

PaLM 2 はより厳しく規制されている

この結果において、LMSYS Orgは特に「Google PaLM 2」に注目しています

PaLM 2は順位で6 位に位置し、高いスコアとなっています、しかし、LMSYS Orgは「PaLM 2は他のモデルに比べて制約が多いようで、ユーザーが曖昧な質問や難しい質問をすると、PaLM 2は他のモデルよりも回答を避ける傾向があります」と述べています

位に位置し、高いスコアとなっています、しかし、LMSYS Orgは「PaLM 2は他のモデルに比べて制約が多いようで、ユーザーが曖昧な質問や難しい質問をすると、PaLM 2は他のモデルよりも回答を避ける傾向があります」と述べています

また、PaLM 2は英語以外の言語(中国語、スペイン語、ヘブライ語など)の質問にはあまり答えない傾向がありました。英語の質問のみを考慮した場合、PaLM 2は5位にランクインしますが、非英語の質問を含めると16位まで順位が下がります

PaLM 2 の推論能力は満足できない

また、提供されている PaLM 2 バージョンが強力な推論機能を実証していないことも観察されています

一方で、質問がプレーン テキストであるかどうかを検出するようですが、プログラミング言語、デバッグ、コード解釈など、プレーン テキストではない多くの質問は拒否される傾向があります

また一方で、他のチャットボットと比較した場合、PaLM 2 はいくつかの初級レベルの推論タスクでうまく機能しなかったことがわかっています

小型モデルは競争力がある

vicuna-7B や mpt-7b-chat などのいくつかの小型モデルがリーダーボードで高い評価を獲得していることがわかります、これらの小さなモデルは、パラメーターが 2 倍になった大きなモデルと比較した場合に有利なパフォーマンスを示します

高品質の事前トレーニングと微調整のデータセットがモデルのサイズよりも重要であると推測しています、ただし、より複雑な推論タスクや、より微妙な質問 (トリビアなど) に答える場合には、より大きなモデルの方がパフォーマンスが向上する可能性があります

したがって、モデルの品質を高く保ちながらモデルのサイズを削減するには、事前トレーニングと微調整の両方の段階で高品質のデータセットをキュレートすることが重要なアプローチであると考えられます

(Via LMSYS Org.)

LEAVE A REPLY